قد تكون المسألة الأخلاقية الروبوتية شائكة نسبياً، فيذهب البعض إلى أن وجود الروبوتات سيساهم في بناء عالم أفضل، و يرى آخرون أن الروبوتات ليس بوسعها أن تصبح كياناتٍ أخلاقية، و ضمن هذا الجدل نخوض في بعص التفاصيل في مقالنا لهذا اليوم.

على من أو ماذا يقع عاتق المسؤولية إذا تعطلت إحدى أنظمة الحكم الذاتي أو تسببت بالضرر للبشر؟

قدم الكاتب الأمريكي (إسحاق عظيموف) Isaac Asimov في أربعينيات القرن الماضي ، القوانين الروبوتية الثلاثة Three Laws of Robotics والتي تناقش مسألة وجوب برمجة الروبوتات الذكية بطريقةٍ تجعلها عند مواجهة أي نزاعٍ تخضع للقوانين الثلاثة التالية:

1. لا يمكن للروبوت التسبب بالأذى للإنسان ، أو أن يتكاسل فيسمح بإصابة الإنسان بأي ضررٍ كان.

2. يلتزم الروبوت بالخضوع للأوامر التي يمليها عليه البشر، بإستثناء إذا كانت تلك الأوامر تتعارض مع القانون الأول.

3. ينبغي على الروبوت

حماية وجوده الخاص، طالما أن هذه الحماية لا تتعارض بالضرورة مع القانون الأول أو الثاني.

و قد تم طرح قوانين (إسحاق عظيموف) عن الروبوتات Isaac Asimov’s Laws of Robotics للمرة الأولي في قصة الخيال العلمي القصيرة (الهارب Runaround)، والتي نُشرت في مارس من عام 1942 في إصدار تابعٍ لمجلة الخيال العلمي المدهشة Astounding Science Fiction.

بالتقدم 80 عاماً في المستقبل، وتحديداً اليوم، نجد أن القوانين الروبوتية الثلاثة (لعظيموف) باتت تمثل مشكلاتٍ وصراعاتٍ بشأن الروبوتات أكثر مما تقدم حلولاً.

ويرى علماء الروبوت، والفلاسفة، والمهندسون أن الجدل ما زال قائماً بشأن الأخلاقية الروبوتية. وتمثل الأخلاقية الروبوتية (الآلية) عرضاً عملياً على كيفية تصميم الروبوتات وتزويدها برادع أخلاقي في الوقت ذاته.

و نعود إلى سؤالنا الذي طرحناه في بداية مقالنا : على من أو ماذا يقع عاتق المسؤولية إذا تعطلت إحدى أنظمة الحكم الذاتي أو تسببت بالضرر للبشر؟

و للإجابة على هذا السؤال في الوقت الحالي، فإن الباحثون يتبعون نزعةً تهدف لتطوير تصميم وتشغيل الأنظمة الذكية بحيث تكون مزودةً بسلوكيات مقبولة أخلاقياً.

عن الأخلاق والأخلاقية الروبوتية

يمثل علم الأخلاق أحد فروع الفلسفة التي تقوم بدراسة السلوك الإنساني، والتقييمات الأخلاقية، ومفاهيم الخير والشر، والحق والباطل، والعدل والظلم.

وينشأ عن مفهوم الأخلاقية الروبوتية تفكير أخلاقي جوهري يرتبط ببعض القضايا والمعضلات الأخلاقية التي انبثقت بُعيد تطوير التطبيقات الروبوتية.

وتتعامل الأخلاقية الروبوتية -و التي يطلق عليها أخلاق الآلة - مع القوانين السلوكية التي يتعين على مهندسي الروبوتات إلحاقها بالذكاء الاصطناعي الخاص بالروبوت.

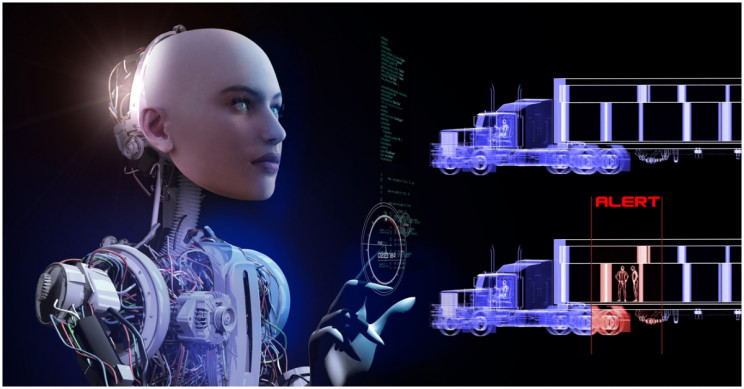

إذ أنه وانطلاقاً من هذا النوع من الأخلاقيات الاصطناعية، يضمن علماء الروبوتات بذلك أن أنظمة الحكم الذاتي ستكون قادرةً على إظهار سلوكيات مقبولة أخلاقياً في المواقف التي تحتك بها الروبوتات أو أية أنظمة حكم ذاتي أخرى مع الإنسان ، مثل المركبات ذاتية القيادة .

و لا شك أن هناك المزيد من القضايا الأخلاقية التي ستستمر في البزوغ كلما دخلت المزيد من الروبوتات المتطورة حيز التنفيذ.

و يدرج الباحثون في كتاب "عن المشاهد الأخلاقية للروبوتات The Ethical Landscape of Robotics " للكاتب (باول لتشوسكي Pawel Lichocki) وآخرون، والمنشور في مجلة (IEEE Robotics and Automation)، قضايا أخلاقية مختلفة تنبثق عن تصميم مجموعتين من التطبيقات الروبوتية: الروبوتات الخادمة Service robots والروبوتات القاتلة lethal robots .

حيث يتم تصميم الروبوتات الخادمة للتفاعل والتعايش بسلام مع الإنسان، بينما تُصمم الروبوتات القاتلة للإرسال إلى ساحة المعركة لتحارب كروبوتات عسكرية.

وتبعاً لكتاب (المشاهد الأخلاقية للروبوتات)، يناقش (نويل شانكي Noel Shanky ) فكرة أن "القدرات المعرفية للروبوتات لا تتوافق مع مثيلاتها لدى البشر، وعليه، فيعد وجود الروبوتات القاتلة أمراً لاأخلاقياً إذ أنها قد تقوم بالأخطاء بسهولة أكبر من البشر.

" بينما يؤمن (رونالد أركين Ronald Arkin) أنه "على الرغم من أن نظاماً ليس مزوداً بالرجال البشريين لن يكون قادراً على التصرف بحنكة في ساحة المعركة، إلا أن هذا النظام بإمكانه التصرف بأخلاقية تفوق أخلاقية البشر."

و يتضمن السؤال -في جزء منه - بشأن مدى أخلاقية استخدام الروبوتات في ساحات المعارك تعهداتٍ حول كفاءة ونوع الذكاء الاصطناعي الذي نحن بصدد الحديث عنه.

الاستعانة بالروبوتات في الجيش: برمجتها على القتل، والمسؤولية الأخلاقية

لا شك أن الروبوتات العسكرية ليست شيئاً جديداً. وإنما يعود تاريخها إلى الحرب العالمية الثانية World War II والحرب الباردة Cold War .

مثل العربات الألمانية الآلية المتعقبة للألغام (The German Goliath)، والدبابات السوفيتية المتحكم بها عن بعد (The Soviet teletanks).

ويمكن تسخير الروبوتات العسكرية لاطلاق النار باستخدام البنادق، أو تفكيك القنابل، أو حمل الجنود الجرحى، أو الكشف عن الألغام، أو إطلاق القذائف، أو الطيران، وهلم جرا.

واليوم، تُطور العديد من الاستخدامات الأخرى للروبوتات العسكرية عن طريق تطبيق تقنيات أخرى على الروبوتات. وتجدر الإشارة إلى أن العسكرية الأمريكية في طريقها لجعل خُمس وحداتها القتالية آليةً بالكامل بحلول عام 2020.

و لنا أن نسأل هنا : ما نوع الأخلاقيات الروبوتية التي يمكن تضمينها بداخل الروبوتات العسكرية؟ ومن سيكون بوسعه الحكم بشأنهم؟ لا شك أنه بسؤالنا هذا إنما تتجلى عدم إمكانية تطبيق قوانين (عظيموف) Asimov's laws على الروبوتات التي تُصمم خصيصاُ لقتل البشر.

و سيقوم الجيش الأمريكي قبل بداية عام 2020 أيضاً ، بمسيرة تجريبية حية لاستعراض المركبات الآلية المدرعة armored robotic vehicles. وقد تم طرح ذلك في مايو بولاية تكساس Texas.

هل ستصبح الروبوتات كياناتٍ أخلاقية في المستقبل؟

لا شك أن أهمية الأخلاقية الروبوتية Roboethics ستزداد بشكلٍ كبير بالتزامن مع العصر الذي ستكون فيه المزيد من الروبوتـات المتقدمة و المتطورة والذكاء العام الاصطناعي Artificial General Intelligence (AGI) جزءاً لا يتجزأ من حياتنا اليومية.

وعليه، ينبغي أن يحتل الجدل القائم حول القضايا الأخلاقية والاجتماعية في الروبوتات المتطورة أهميةً متزايدة.

حيث يستلزم التطور الحالي للروبوتات والتقدم السريع في الذكاء الاصطناعي أن يكون علماء الروبوتات والبشر جميعاً مستعدين لذلك الأمر عاجلاً غير آجلاً.

وبينما يحتدم النقاش بشأن الأخلاقية الروبوتية، يذهب البعض إلى أن وجود الروبوتات سيساهم في بناء عالم أفضل، غير أن البعض الآخر يرى أن الروبوتات ليس بوسعها أن تصبح كياناتٍ أخلاقية، ولا يجب أن تُصمم مزودةً بقدرات على اتخاذ قراراتٍ أخلاقية.

وفي النهاية، ربما ليس الآن ولكن مستقبلاً ستتمكن الروبوتـات من أن تصبح كياناتٍ أخلاقية و توكل إليها المسؤولية الأخلاقية. وحتى حدوث ذلك، لابد أن يدرك مهندسو ومصممو الروبوتات مسؤوليتهم الكاملة عن العواقب الأخلاقية لما تصنعه أياديهم.

وبتعبيرٍ آخر، ينبغي أن يكون مهندسو ومصممو الروبوتات مسؤولين أخلاقياً عن كل ما يقومون بتصميمه وإخراجه إلى العالم.

ترجمة: سارة تركي